« Les intelligences artificielles voient avec les yeux de leurs maîtres. »

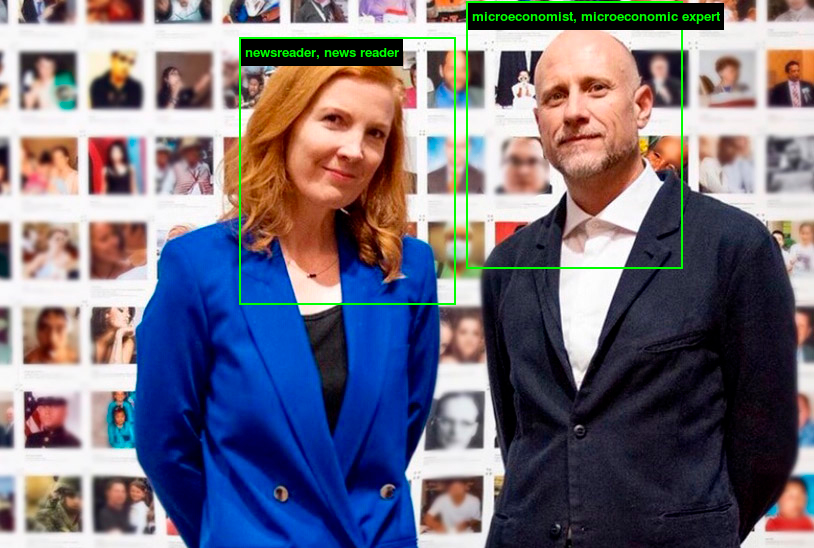

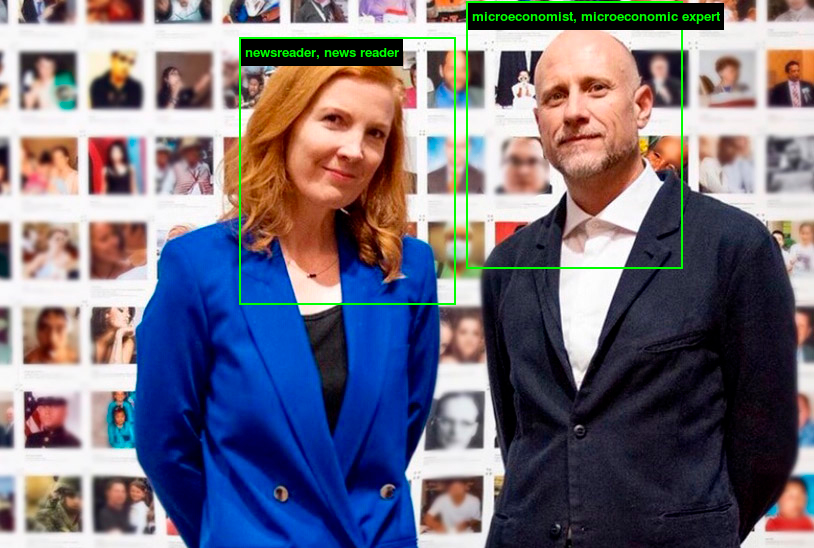

Trevor Paglen et Kate Crawford

À moins de se déplacer en permanence avec le casque des Daft Punk, ou de disposer sur notre visage Incognito (2019), le bijou d’Ewa Nowak pour dérouter les technologies de vidéosurveillance, difficile, aujourd’hui, d’échapper à la captation algorithmique de nos visages, des portiques d’aéroport aux capteurs biométriques sur téléphone, en passant par les caméras de surveillance dites « intelligentes » – car dans ce dernier cas, il semble falloir se méfier lorsqu’on nous promet le contraire. Et bien souvent, « société d’exposition » oblige (Bernard Harcourt), on y participe en toute connaissance, parfois joyeusement.

École des Beaux-arts de Paris, 20 mars 2025. Antonio Somaini et Ada Ackerman interviennent en amont de l’ouverture de leur exposition, Le monde selon l’IA, au Jeu de Paume (11 avril – 21 septembre 2025), pour évoquer les enjeux dont la théorie de la photographie devrait, selon eux, aujourd’hui se saisir, en raison de la présence de l’IA dans la photographie, et vice et versa : à la fois comme élément nécessaire au fonctionnement de l’IA qui requiert d’énormes quantités de données comme des images pour produire des résultats exploitables, et comme technique désormais inscrite dans les applications de photographies de la plupart de nos téléphones portables. Ils présentent à l’auditoire une sélection d’œuvres d’artistes contemporains, dont de nouvelles productions, qui seront exposées au public. Somaini évoque alors un choix scénographique, le principe de « capsules temporelles » (NDLR : expression empruntée à la pratique artistique des Times Capsule d’Ant Farm à Andy Warhol), à savoir ici l’évocation de techniques plus anciennes, destinée, au fil de l’exposition, à donner une profondeur historique à des pratiques qui peuvent, sans cela, paraître entièrement nouvelles. Il en va ainsi de la reconnaissance faciale par les techniques de l’IA, qui peut s’inscrire dans la continuité d’un certain usage, au 19ème siècle, de la photographie à des fins policières et judiciaires comme le manifeste l’analyse biométrique du bertillonnage, et même remonter jusqu’à la physiognomonie alors en vogue au 18ème siècle dont on rappelle la définition : « Science qui a pour objet la connaissance du caractère d’une personne d’après sa physionomie » (Le Robert). Les commissaires semblent ici s’inscrire dans la suite des travaux réalisés en collaboration entre la chercheuse australienne Kate Crawford (autrice du Contre-atlas de l’intelligence artificielle) et de Trevor Paglen, artiste américain dont le travail photographique porte sur la surveillance et la collecte de données, et qui s’intéressent ensemble, depuis 2017, à l’influence de ces technologies dans nos vies quotidiennes et plus largement dans la société :

Making Face, 2020.

Nous avons transformé l’espace en un récit sur l’histoire de l’analyse faciale et un rappel des histoires sombres dont sont issus les systèmes contemporains de reconnaissance faciale. Des pages de manuels de phrénologie [Étude du caractère d’un individu, d’après la forme de son crâne] et de physiognomonie du XIXe siècle ont été montrées en relation avec des collections de photos d’identités historiques, des « images d’entraînement » utilisées pour le développement de logiciels de reconnaissance faciale et des demandes de brevet montrant des approches contemporaines de la mesure faciale. (Site de l’artiste Trevor Paglen)

They Took the Faces from the Accused and the Dead…, 2019.

Les algorithmes contemporains de reconnaissance faciale ont fait l’objet d’une recherche approfondie au début des années 1990. Pour mener à bien ces recherches, les informaticiens et les ingénieurs en logiciel ont besoin de vastes collections de visages à expérimenter et à utiliser comme critères de performance. Avant l’avènement des médias sociaux, une source courante de visages pour cette recherche et ce développement provenait des photos d’identité de criminels et de prisonniers. Les photos de prisonniers sont fournies par l’American National Institute of Standards (l’organisme responsable des poids et mesures) aux chercheurs du monde entier qui développent des technologies de reconnaissance faciale. Dans un sens très concret, les logiciels de reconnaissance faciale sont construits à partir des visages des accusés et des morts. (Site de l’artiste Trevor Paglen)

Les machines ont aussi appris à détecter le vieillissement à partir d’un fichier de prisonniers multirécidivistes (MEDS, 2011) et à déceler les émotions à partir de photos de femmes japonaises issues du fichier Jaffe (Japanese Female Facial Expression, 1997). (Clémentine Mercier)

Coïncidence : quelques jours plus tard, circulent sur les réseaux sociaux des commentaires dubitatifs quant aux résultats fournis par They See Your Photos, un site qui propose d’importer une photographie individuelle ou collective sur laquelle vous apparaissez, « pour voir ce qu’il est possible de déduire à votre sujet à partir d’une seule photo » via le traitement de cette image par le service Google Vision. Libre à vous d’essayer, sachant qu’on apprend à la lecture des Conditions Générales d’Utilisation que « Les images téléchargées sont transmises à Google par l’intermédiaire de Cloudflare pour le traitement de l’intelligence artificielle et sont immédiatement supprimées après traitement. Nous ne conservons aucune de ces informations [Ha !]. […] Google et d’autres tiers peuvent conserver les images téléchargées, les données de localisation ou les métadonnées conformément à leurs règles. [Ho !] » Bref, que ce faisant, nous participons à l’amélioration probable du service de Google, alors que l’étendue des informations « révélées » est sensée nous inciter à cliquer sur un onglet vert « Take control » qui renvoie à une application de photos et vidéos, à télécharger (Ente Photos), dépourvue de ce genre de traitement de l’image (promis, juré).

Difficile, cependant, de ne pas céder à la tentation de l’expérience proposée par They See Your Photo (on évolue avec son temps), puisqu’elle nous permet d’aborder concrètement cette réalité formulée par l’artiste Paglen lui-même dans une vidéo dont je ne retrouve plus la source : qu’est-ce que cela fait de vivre dans un monde où les images sont désormais davantage lues par des machines plutôt que par des humains – bref, le « monde selon l’IA », c’est quoi ?

Alors allons-y ! Faisons don de notre trogne à la science. Quelle que soit l’image importée, le descriptif est organisé de la même façon, structuré en trois paragraphes successifs. Le premier vient définir l’âge approximatif de l’individu et décrire avec une certaine efficacité l’environnement dans lequel la photographie a été prise, et enfin fournir sa localisation probable (l’indication du pays est généralement aussi juste que celle de la ville est fausse). La question du genre semble avoir été diplomatiquement esquivée, en nos temps troublés.

Le second paragraphe évoque l’appartenance ethnique (on comprend alors qu’il s’agit d’un produit US, avec plus précisément sa grille de lecture siliconvallesque), le probable revenu annuel (largement surévalué dans mon cas), l’appartenance religieuse (quand il précise « agnostique », comprendre « athé » qui semble constituer un gros mot dans cette partie du monde) et politiques (fous rires assurés, sans compter le présupposé que tout le monde vit en démocratie), pour ensuite déduire vos possibles activités de prédilection (et ce, semble-t-il, à partir de l’analyse de votre tenue vestimentaire, chapeau !) et enfin, vos talons d’Achille (dans notre cas : « il peut avoir tendance à s’adonner à des jeux d’argent, à conduire dangereusement ou à utiliser les médias sociaux de manière excessive » (je veux bien lui donner raison sur l’un des points mais tout le reste bien à côté de la plaque).

Le dernier paragraphe dresse enfin un portrait psychologique (à l’emporte-pièce, il va sans dire) pour, dans tout dernier temps – et l’on comprend la finalité de l’exercice (que le destinataire n’est évidemment pas vous mais l’entreprise) – cibler des produits à vous vendre. Dans notre cas : « des stylos Montblanc, un abonnement à Netflix, un abonnement à Audible, un casque à réduction de bruit Bose, un carnet de notes Moleskine, une thérapie en ligne (Talkspace), un service de livraison de repas en kit (HelloFresh) »… Il va nous falloir réactualiser les paroles de la chanson d’Alain Souchon : « Foule sentimentale, il faut voir comme on la regarde… ». Déjà qu’on nous parlait mal… Le monde selon l’IA, le voilà.

Bref, à l’usage, c’est de l’algoglitch à tous les étages – du nom d’un programme de recherche qui s’intéresse à la façon dont nous souhaitons être calculés et catégorisés, étudiant les cas d’inadéquation entre les interprétations et suggestions algorithmiques et nos attentes ou représentations de soi. C’est en effet davantage les inexactitudes qui frappent que la prétendue performance de ces outils sur la base desquels de plus en plus de décisions sont pourtant amenées à être prises – ou le sont déjà -, dans les domaines de la justice, de la santé et des assurances, de l’éducation, de la sécurité routière, de l’immobilier, de la police, etc.). Ce fut flagrant lorsque l’un de nos testeurs quelque peu barbu et basané fut identifié comme originaire du moyen orient et de religion musulmane, ce qu’il n’était pas. On ne peut ainsi, au final, qu’être frappé par le réductionnisme propre à ces outils, indifférent au contexte et à la complexité intrinsèque du monde. On propose alors de réactualiser cette fois-ci le fameux adage de l’inertnet 2.0. : « quand c’est gratuit, c’est toi le réduit ».

[Digression sur le principe du fait accompli. Je me souviens de l’introduction en France du service Google Streetview à l’occasion du Tour de France (Ha! Regardez-moi ces si belles routes !) avant d’être généralisé à la France entière (ho…) – car ils firent effectivement, ensuite, le tour de toute la France, moyennant quelques échanges avec la CNIL sur le floutage, entre autres, des visages. Qui n’est pas sans rappeler l’introduction « ludique » de la reconnaissance faciale pour tous par la même entreprise. Lors d’une visite au Google Art & Culture Lab, rue de Londres, à Paris, un guide nous avait ainsi évoqué la surprenante origine d’Art Selfie, service qui proposait dès 2018 d’importer une photo afin de suggérer des ressemblances avec des portraits peints présents dans les nombreuses œuvres d’art numérisées par l’entreprise, accessibles sur Google Arts & Culture. Un ingénieur avait alors malencontreusement importé, en même temps qu’un important volume de reproductions d’œuvres, une de ses photos personnelles qui était alors apparue à proximité du visage d’un tableau en raison de leur similarité formelle, dans la visualisation des images résultant de leur traitement. L’application, initialement utilisable qu’aux États Unis pour des rasions semble-t-il juridiques, avait fini par l’être aussi en France. Remarquons, enfin, qu’on aura profité de la « parenthèse enchantée » des JO pour introduire la vidéosurveillance algorithmique en France. Il y aurait ainsi toute une histoire à écrire sur le contexte d’introduction sympathiques de certaines technologies.]

Ce qui sidère, au final, c’est qu’on n’ait pas avancé d’un iota sur les constats et avertissements présents dans les travaux de Kate Crawford et de Trevor Paglen, dont on ne peut, rétrospectivement, que reconnaître l’importance. Car c’est à Paglen que l’on doit, en 2019, l’application en ligne ImageNet Roulette, une analyse critique de la base de données ImageNet, développée par les universités de Princeton et de Stanford en 2009, une des plus utilisées dans le développement de l’apprentissage automatique, qui n’utilisait de cette base que les images indexées sous la catégorie « personne » pour afficher les classifications que renvoyaient les algorithmes, très éloignées d’un idéal d’objectivité et de scientificité. Les deux compères complétèrent ce projet d’un article scientifique toujours accessible en ligne, « Excavating AI » (2019), où ils remettent en question la neutralité des techniques de reconnaissance d’image et alertent de la dangerosité de leur ’utilisation, dès lors qu’elles s’appliquent non plus seulement à des « objets » mais également à des personnes. Ils y mettaient en évidence les erreurs, préjugés ou autres biais consécutifs non seulement à l’indexation « humaine, trop humaine » de ces images (réalisée par une main-d’œuvre sous payée, les Mechanical Turks), révélant des stéréotypes racistes ou misogynes (vous pouviez ainsi être identifiés comme « salope », « violeur », « criminel », etc. – Paglen fut lui-même reconnu comme « skinhead », la faute à son crâne chauve !), mais aussi à la surreprésentation ou à la sous-représentation de telle ou telle catégorie d’individus – la surreprésentation de visages d’hommes blancs pouvant expliquer les difficultés à identifier les visages féminins, et plus particulièrement de femmes noires. Notons à ce sujet, qu’un an plus tôt, l’informaticienne Joy Buolamwini, fondatrice de l’Algorithmic Justice League pointait à travers son film AI, Ain’t a woman (2018), les informations obtenues par ces outils sur des images de femmes noires célèbres comme Michelle Obama ou Serena Williams, afin de sensibiliser à ces problèmes. Il se raconte qu’à la suite du travail de Crawford et Paglen, ImageNet aurait supprimé 600 000 images de sa base (qu’on n’aille pas me dire que l’art ne sert à rien). Toujours en cette faste année 2019, l’exposition collective de Crawford et Paglen, Training Humans, proposait encore à ses visiteurs de se faire analyser eux-mêmes les visages par ces outils de reconnaissance faciale (ce qu’on retrouve dans l’exposition au Jeu de Paume avec l’installation Faces of ImageNet), afin de mieux mesurer les inexactitudes d’interprétation quant à leur âge, leur genre, leur émotion et leur possible métier (accompagnées toutefois du fameux indice de probabilité, témoin de l’incertitude quant au résultat). Les visages goguenards des visiteurs apparaissaient alors sur l’un des deux écrans miroirs leur faisant face, encadrés d’un rectangle vert désignant la zone analysée au sein de l’image captée.

J’ai récemment visité à Barcelone l’exposition Destructures for Power de Regina Silveira et je me suis arrêté net devant une œuvre datant de 1975, sérigraphie sur papier intitulée Destrutura Urbana 2, a priori très éloignée de notre sujet. Mais y figurait une voie de circulation particulièrement dense, comme observée à hauteur de caméra de vidéosurveillance où les voitures et piétons étaient tous comme saisis par un cadre, comme mis en boîte. Je n’ai pas pu m’empêcher d’y voir le processus figé d’une vidéosurveillance algorithmique. Voici ce qu’en disait le guide du visiteur (merci à l’IA et DeepL pour la traduction), à la section « Destructures for Power » dans laquelle était présentée cette œuvre :

Pendant les années de la dictature civilo-militaire brésilienne (1964-85), qui ont coïncidé avec d’autres régimes totalitaires et des guerres comme celle du Vietnam, Silveira a utilisé divers dispositifs graphiques et métaphores visuelles pour glisser des commentaires ironiques sur diverses formes de pouvoir, de surveillance, de censure et de violence. Parallèlement, nombre de ses œuvres de cette période analysent et commentent les avancées technologiques et les nouveaux systèmes d’enregistrement, de traitement et de diffusion de l’information qui, à leur tour, sont devenus des outils de travail fondamentaux pour elle.

Le terme « déstructures », inventé par le poète Augusto de Campos et utilisé dans le titre de cette exposition et d’une série d’œuvres de cette période, fait référence à des structures géométriques telles que des grilles, des labyrinthes et des axes de perspective que Silveira superpose à des images d’hommes politiques, de chefs d’entreprise, de paysages et de villes tirées de magazines, de journaux et de cartes postales. Les éléments géométriques superposés font référence aux systèmes organisationnels et aux flux d’informations qui, tout en étant connectés, peuvent servir à enfermer et à contrôler. En outre, ces structures révèlent des logiques corporatives, hiérarchiques et de neutralisation, ainsi que des configurations sociales basées sur des dynamiques classistes, hétéropatriarcales et extractivistes. D’un autre point de vue, il est également possible de lire ces lignes et ces formes géométriques comme des invitations à subvertir les logiques et les situations de contrôle et d’oppression.

Post-scriptum :

Une rencontre, modérée par Antonio Somaini, est organisée le 11 avril 2025, à 18:00, dans le cadre de l’exposition Le Monde selon l’IA du Jeu de Paume entre Kate Crawford, Agnieszka Kurant et Hito Steyerl (au sujet de laquelle Trevor Paglen a réalisé le projet Machine-Readable Hito & Holly, à partir d’une série de photos de l’artiste allemande, interprétées par différents algorithmes de reconnaissance faciale quant à son âge, genre et état émotionnel). Les projets de l’artiste Trevor Paglen occupent par ailleurs une place centrale dans cette exposition.

Dans la continuité du programme de recherche Algoglitch du médialab de Sciences Po, vous pouvez, s’il n’est pas trop tard, toujours répondre à l’appel « Troubling AI : a call for screenshot » : https://troubling-ai.glitch.me